| 编辑推荐: |

本文主要介绍了阿里大模型与aigc

。希望对你的学习有帮助。

本文来自于搜狐,由火龙果软件linda编辑,推荐。 |

|

一、前言

行业大佬都在投身大模型赛道,大模型有什么魅力?chatgpt火热,是人类生产力的解放?

二、大模型

2.1 不是模型参数大就叫大模型

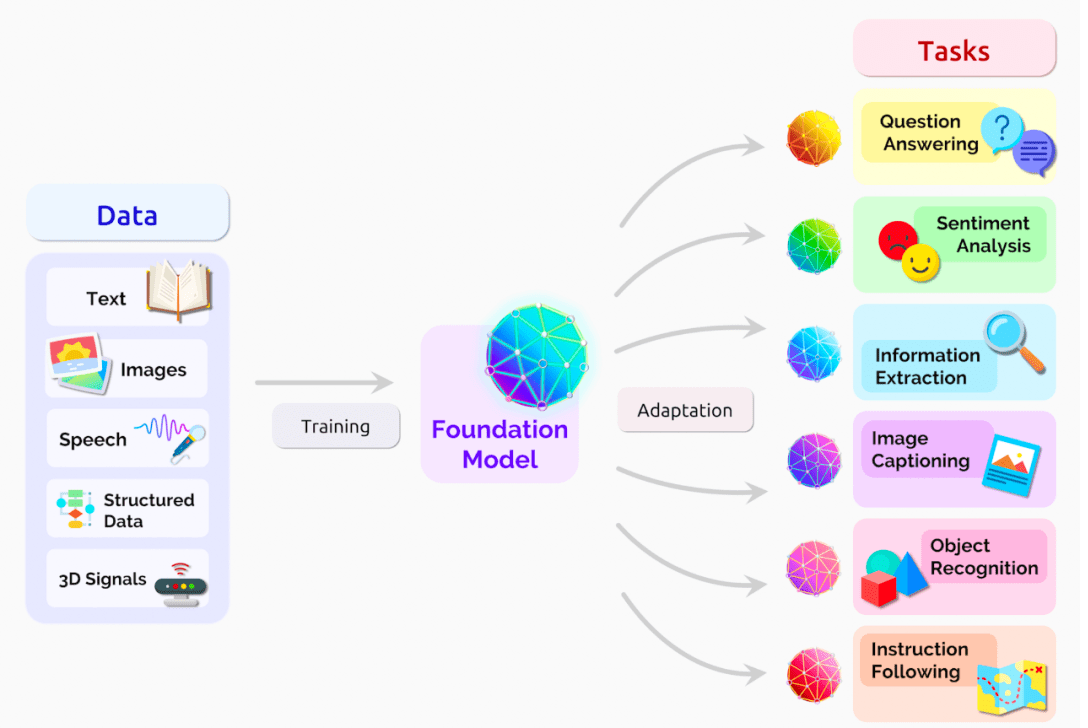

关于大模型,有学者称之为“大规模预训练模型”(large pretrained language

model),也有学者进一步提出”基础模型”(foundation models)的概念

2021年8月,李飞飞、percy liang等百来位学者联名发布了文章:on the opportunities

and risks of foundation models[1],提出“基础模型”(foundation

models)的概念:基于自监督学习的模型在学习过程中会体现出来各个不同方面的能力,这些能力为下游的应用提供了动力和理论基础,称这些大模型为“基础模型”。

“小模型”:针对特定应用场景需求进行训练,能完成特定任务,但是换到另外一个应用场景中可能并不适用,需要重新训练(我们现在用的大多数模型都是这样)。这些模型训练基本是“手工作坊式”,并且模型训练需要大规模的标注数据,如果某些应用场景的数据量少,训练出的模型精度就会不理想。

“大模型”:在大规模无标注数据上进行训练,学习出一种特征和规则。基于大模型进行应用开发时,将大模型进行微调(在下游小规模有标注数据进行二次训练)或者不进行微调,就可以完成多个应用场景的任务,实现通用的智能能力。

2.2 大模型赛道早已开始

多语言预训练大模型

facebook已发布了一个百种语言互译的模型m2m-100,该模型不依赖英文作为中介语言,可实现一百种语言之间的直接翻译,在机器翻译领域实现新突破。

谷歌宣布开源了多语言模型mt5,基于101种语言进行训练,采用750gb文本,最大含有130亿个参数,

目前已在大多数多语言自然语言处理任务基准测试中达到最优水平,包括机器翻译、阅读理解等。

多模态预训练大模型

openai已研发dall·e、clip等多模态模型,参数达120亿,在图像生成等任务上取得优秀表现。

多任务预训练大模型

谷歌在2022年的io大会上公开了mum(多任务统一模型 : multitask unified

model)的发展情况。据谷歌透露,mum模型基于大量的网页数据进行预 训练,擅长理解和解答复杂的决策问题,能够理解75种语言,从跨语言多模态网页数据中寻找信息。

视觉预训练大模型

具备视觉通用能力的大模型,如vitransformer等。视觉任务在日常生活和产业发展中占据很大的比重,视觉大模型有可能在自动驾驶等依赖视觉处理的领域加速应用。

2.3 深度学习范式即将改变

ai的研发和应用范式可能会发生极大的变化,各位大佬或许也是因为看到了深度学习2.0时代的到来,纷纷投身大模型赛道。

上图源自李飞飞、percy liang等百来位学者联名发布的文章[1]

machine learning homogenizes learning algorithms

(e.g., logistic regression), deep learning homogenizes

model architectures (e.g., convolutional neural networks),

and foundation models homogenizes the model itself

(e.g., gpt-3)

如文中所说,机器学习同质化学习算法(例如逻辑回归)、深度学习同质化模型结构(例如cnn),基础模型则同质化模型本身(例如gpt-3)。

人工智能的发展已经从“大炼模型”逐步迈向了“炼大模型”的阶段。chatgpt只是一个起点,其背后的foundation

module的长期价值更值得被期待。

2.4 大模型不是一跃而起的

大模型发展的前期被称为预训练模型,预训练技术的主要思想是迁移学习。当目标场景的数据不足时,首先在数据量庞大的公开数据集上训练模型,然后将其迁移到目标场景中,通过目标场景中的小数据集进行微调

,使模型达到需要的性能 。在这一过程中,这种在公开数据集训练过的深层网络模型,被称为“预训练模型”。使用预训练模型很大程度上降低下游任务模型对标注数据数量的要求,从而可以很好地处理一些难以获得大量标注数据的新场景。

2018年出现的大规模自监督(self-supervised)神经网络是真正具有革命性的。这类模型的精髓是从自然语言句子中创造出一些预测任务来,比如预测下一个词或者预测被掩码(遮挡)词或短语。这时,大量高质量文本语料就意味着自动获得了海量的标注数据。让模型从自己的预测错误中学习10亿 次之后,它就慢慢积累很多语言和世界知识,这让模型在问答或者文本分类等更有意义的任务中也取得好的效果。没错,说的就是bert和gpt-3之类的大规模预训练语言模型,也就是我们说的大模型。

2.5 为什么大模型有革命性意义?

突破现有模型结构的精度局限

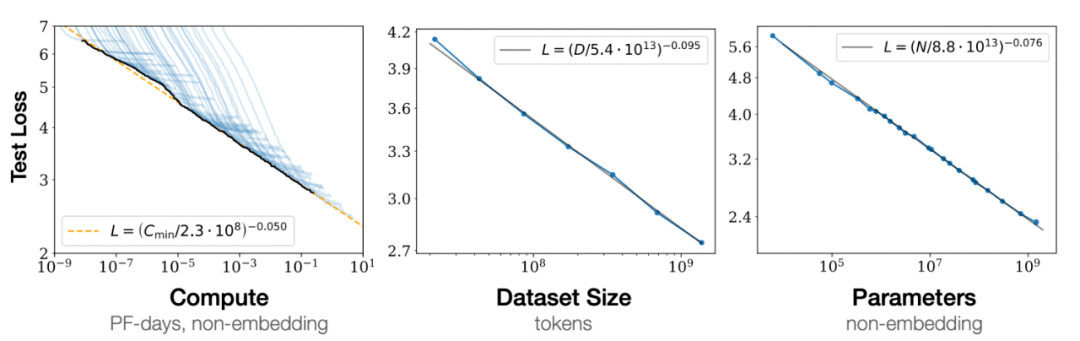

2020年1月,openai发表论文[3],探讨模型效果和模型规模之间的关系。

结论是:模型的表现与模型的规模之间服从power law,即随着模型规模指数级上升,模型性能实现线性增长

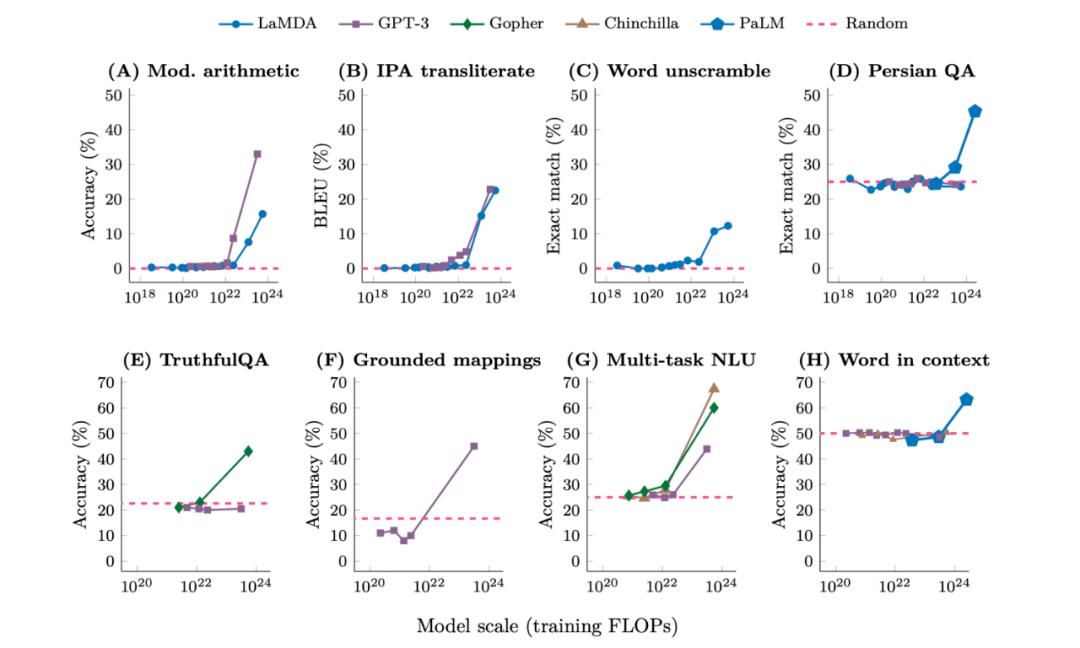

2022年8月,google发表论文[4],重新探讨了模型效果与模型规模之间的关系。

结论是:当模型规模达到某个阈值时,模型对某些问题的处理性能呈现快速增长。作者将这种现象称为emergent

abilities,即涌现能力。

预训练大模型 细分场景微调更适合长尾落地

用著名nlp学者斯坦福大学的chris manning教授[2]的话来说,在未标注的海量语料上训练大模型可以:

produce one large pretrained model that can be very

easily adapted, via fine-tuning or prompting, to give

strong results on all sorts of natural language understanding

and generation tasks.

通过微调或提示,大规模预训练模型可以轻松地适应各种自然语言理解和生成任务,并给出非常强大的结果。

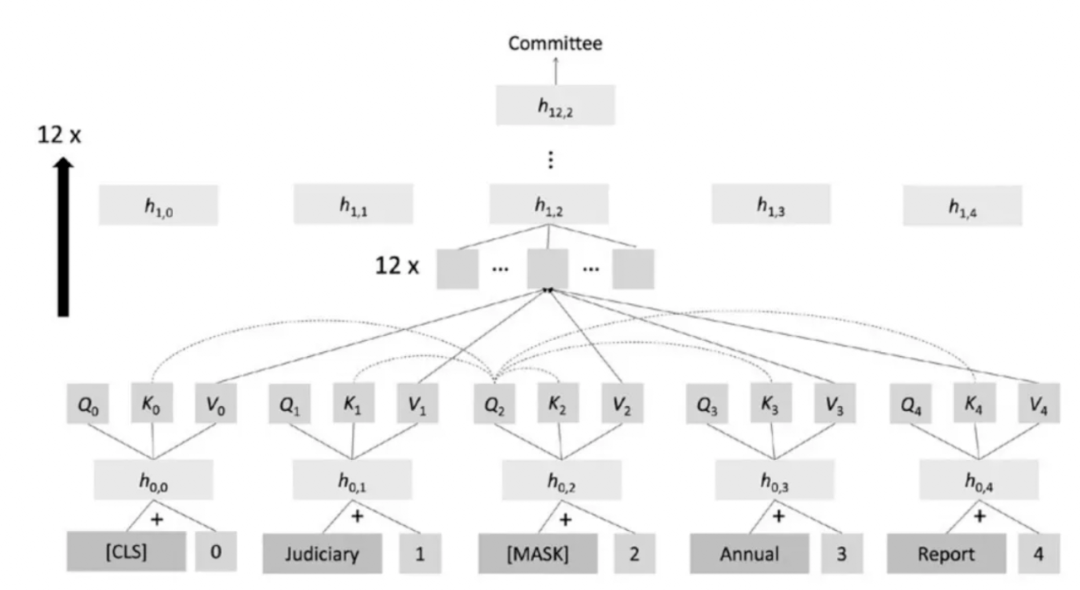

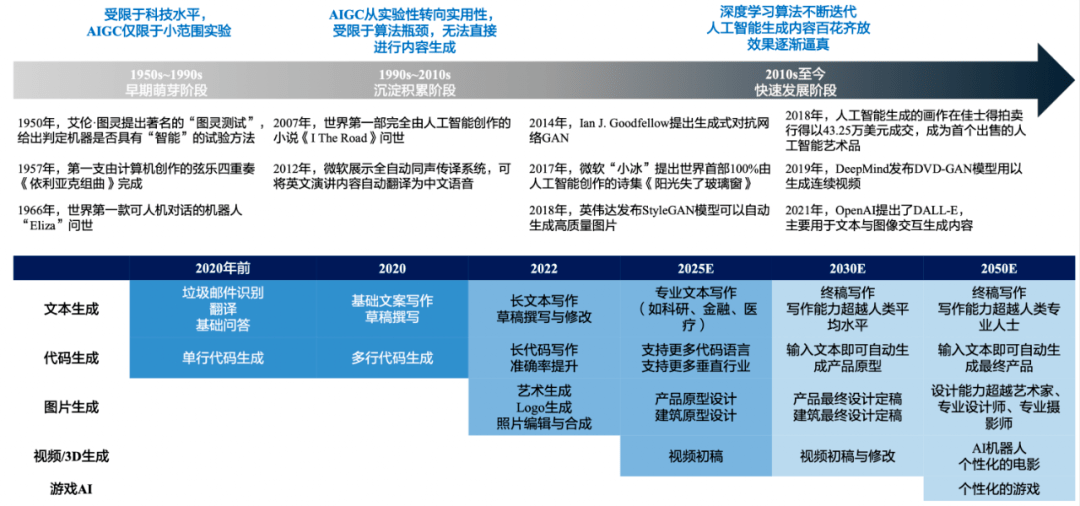

transformer 架构自2018年开始统治nlp领域,nlp领域的进展迎来了井喷。为何预训练的transformer有如此威力?其中最重要的思想是attention,也就是注意力机制。attention其实非常简单,就是句子中每个位置的表征(representation,一般是一个稠密向量)是通过其他位置的表征加权求和而得到。transformer模型通过每个位置的query,

key以及value的表征计算来预测被掩码位置的单词,大致过程如下图所示,更具体的细节这里不再赘述。

2.6 为什么这么简单的结构和任务能取得如此威力?

原因在其通用性。

预测下一个单词这类任务简单且通用,以至于几乎所有形式的语言学和世界知识,从句子结构、词义引申、基本事实都能帮助这个任务取得更好的效果。大模型也在训练过程中学到了这些信息,让单个模型在接收少量的指令后就能解决各种不同的nlp问题。也许,大模型就是“大道至简”的最好诠释。

基于大模型完成多种nlp任务,在2018年之前靠fine-tuning(微调),也就是在少量针对任务构建的有监督数据上继续训练模型。后来则出现了prompt(提示学习)这种形式,只需要对任务用语言描述或者给几个例子,模型就能很好的执行以前从未训练过的任务。

大模型还改变了nlp的范式

传统的nlp是流水线范式:先做词法(如分词、命名实体识别)处理,再做句法处理(如自动句法分析等),然后再用这些特征进行领域任务(如智能问答、情感分析)。这个范式下,每个模块都是由不同模型完成的,并需要在不同标注数据集上训练。而大模型出现后,就完全代替了流水线模式,比如:

机器翻译:用一个模型同时搞多语言对之间的翻译

智能问答:基于lplm(large pretrained language model)微调的模型效果明显提升

其他nlu(natural language understanding)任务如ner(named

entity recognition)、情感分析也是类似

更值得一提的是 nlg (natural language generation),大模型在生成通顺文本上取得了革命性突破,对于这一点玩过chatgpt的同学一定深有体会。

大模型能在nlp任务上取得优异效果是毋庸置疑的,但我们仍然有理由怀疑大模型真的理解语言吗,还是说它们仅仅是鹦鹉学舌?

2.7 大模型能真正理解人类语言吗?

要讨论这个问题,涉及到什么是语义,以及语言理解的本质是什么。关于语义,语言学和计算机科学领域的主流理论是指称语义(denotational

semantics),是说一个单词短语或句子的语义就是它所指代的客观世界的对象。与之形成鲜明对比的是,深度学习nlp遵循的分布式语义(distributional

semantics),也就是单词的语义可以由其出现的语境所决定。

meaning arises from understanding the network of

connections between a linguistic form and other things,

whether they be objects in the world or other linguistic

forms.

意义来源于理解语言形式与其他事物之间的连接,无论它们是语言形式还是世界上其他的物体。

引用nlp大佬manning的原话,用对语言形式之间的连接来衡量语义的话,现在的大模型对语言的理解已经做的很好了。但局限性在于,这种理解仍然缺乏世界知识,也需要用其他模态的感知来增强,毕竟用语言对图像和声音等的描述,远不如这些信号本身来的直接。(没错,gpt-4!)

三、aigc(ai generated content)

在大模型的加持下,aigc有望帮助内容生成跨越新时代。

3.1 简单认识aigc

什么是aigc?

目前,对aigc这一概念的界定,尚无统一规范的定义。国内产学研各界对于aigc的理解是“继专业生成内容(professional

generated content,pgc)和用户生成内容(user generated content,ugc)之后,利用人工智能技术自动生成内容的新型生产方式”。

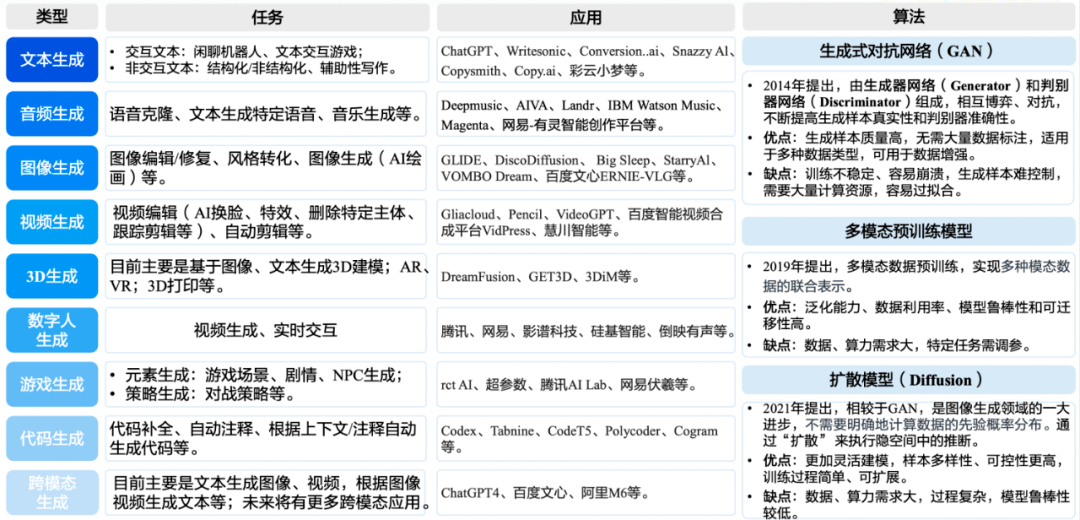

aigc能做什么?

aigc的发展历程

3.2 aigc热门技术

aigc技术中,耳熟能详的当属gpt和stable diffusion了,作为一个技术er,应当了解一下其中的核心技术:transformer、gpt、diffusion、clip、stable

diffusion

3.2.1 transformer

transformer主要用在语言模型(lm)上,transformer是一个完全依赖于自注意力机制(self-attention)来计算其输入和输出的表示的转换模型,可以并行同时处理所有的输入数据,模仿人类联系上下文的习惯,从而更好地为大语言模型(llm)注入意义并支持处理更大的数据集。

自注意力机制(self-attention):例:翻译the animal didn't cross

the street because it was too tired. 以前的模型在处理该句子时,无法像人类一样判断it代指animal还是street,而self-attention机制的引入使得模型不仅能够关注当前位置的词,还能够关注句子中其他位置的词,从而在翻译时关联it和animal,提高翻译质量

语言模型(lm)是指对语句概率分布的建模。具体是判断语句的语序是否正常,是否可以被人类理解。它根据句子中先前出现的单词,利用正确的语序预测句子中下一个单词,以达到正确的语义。例如,模型比较“我是人类”和“是人类我”出现的概率,前者是正确语序,后者是错误语序,因此前者出现的概率比后者高,则生成的语句为“我是人类”

大型语言模型(llm)是基于海量数据集进行内容识别、总结、翻译、预测或生成文本等的语言模型。相比于一般的语言模型,llm

识别和生成的精准度会随参数量的提升大幅提高。

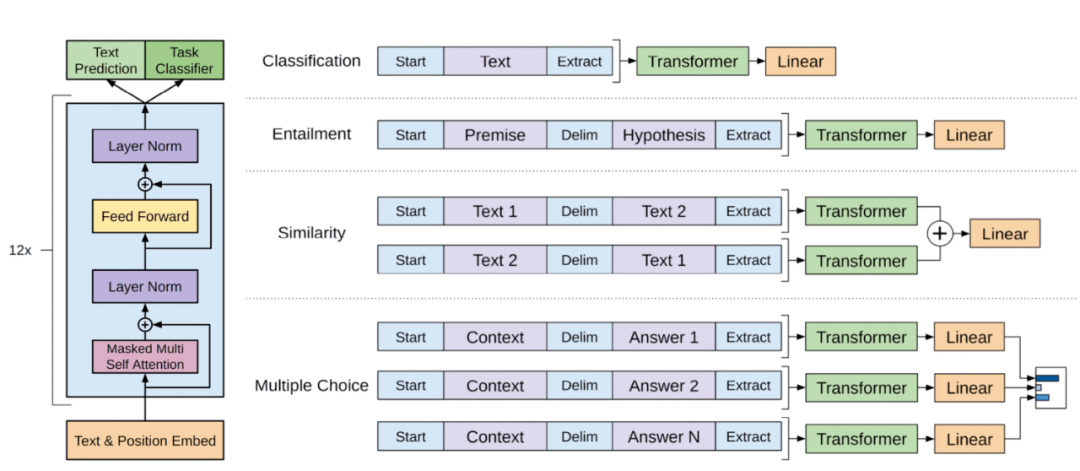

这里仅列出了transformer整体模型。

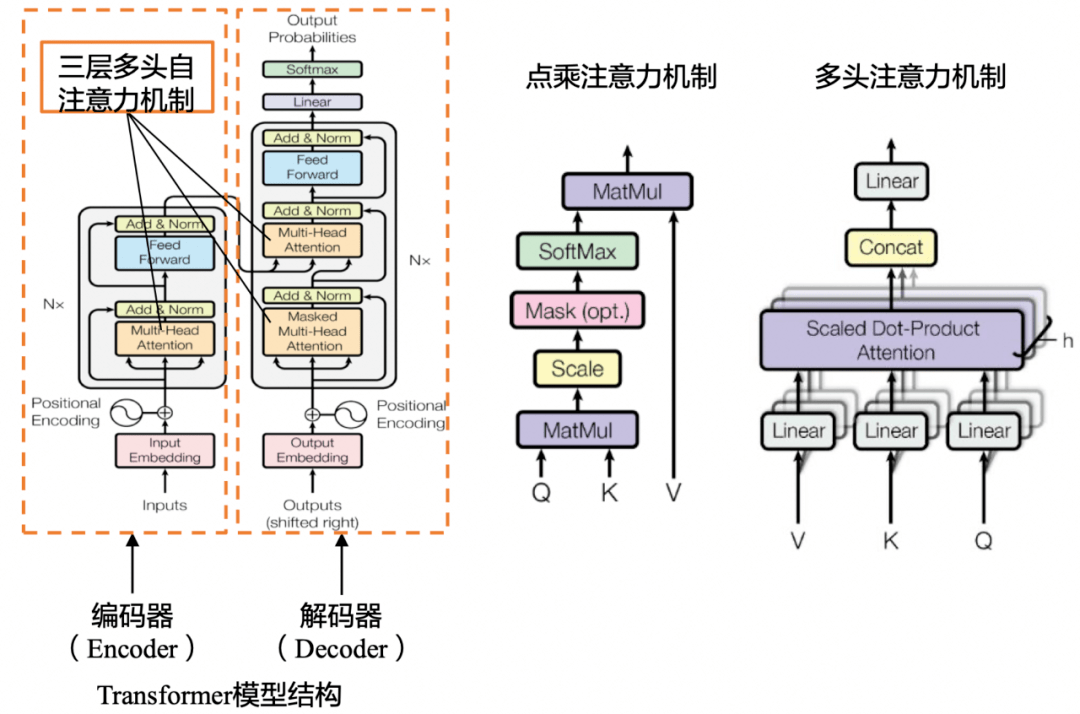

3.2.2 gpt

当前最热门的大模型chatgpt,其采用的大规模预训练模型gpt-3.5,核心便是transformer和rlhf两种语言模型。gpt的全称是generative

pre-trained transformer,顾名思义,gpt的目的就是以transformer为基础模型,使用预训练技术得到通用的文本模型。

预训练:指先通过一部分数据进行初步训练,再在这个训练好的基础模型上进行重复训练,或者说“微调”;

推理:指将预训练学习到的内容作为参考,对新的内容进行生成或判断。

预训练是模型运作的主要部分,所需要的精度较高,算力需求也较高;推理则相反。

人类反馈信号强化学习(rlhf):指使用强化学习的方式直接优化带有人类反馈的语言模型,使得语言模型能够与复杂的人类价值观“对齐”。它负责

chatgpt 预训练中微调的部分,首先在人类的帮助下训练一个奖赏网络(rm),rm 对多个聊天回复的质量进行排序,

从而增加 chatgpt 对话信息量,使其回答具有人类偏好。

目前已经公布论文的有文本预训练gpt-1,gpt-2,gpt-3,以及图像预训练igpt。gpt-4是一个多模态模型,具体细节没有公布。最近非常火的chatgpt和今年年初公布的instructgpt是一对姐妹模型,是在gpt-4之前发布的预热模型,有时候也被叫做gpt3.5。chatgpt和instructgpt在模型结构,训练方式上都完全一致,即都使用了指示学习(instruction

learning)和人工反馈的强化学习(reinforcement learning from human

feedback,rlhf)来指导模型的训练,它们不同的仅仅是采集数据的方式上有所差异。如下图所示,gpt-1,gpt-2,gpt-3三代模型都是采用的以transformer为核心结构的模型,不同的是模型的层数和词向量长度等超参。

(其中trm是一个transformer结构)

下面将从gpt-1、gpt-2、gpt3、gpt3.5一直到gpt4,对gpt做一个简单介绍。

gpt-1

主要解决的问题:怎么在无标号数据上面预训练大模型?

gpt使用语言模型来进行预训练,并使用了n-gram方法对当前单词进行预测。通俗的说,也就是根据前k个单词来预测下一个单词谁什么,大量高质量文本语料就意味着自动获得了海量的标注数据。最关键的是如何优化目标函数,因为不同的任务目标函数设定是不一样的。gpt使用对数最大似然函数来计算loss,使用transformer的解码器(因为有掩码不能看到完整的句子信息),并且其中使用了position

embedding引入了位置信息。

怎么做模型微调?

微调时使用的是带有标号的数据集,每次输入长度为m的一条序列x,这条序列有一个标号y。模型根据输入的序列x预测其标号y(标准分类任务)。要考虑的是如何将nlp下游的子任务表示成我们想要的形式,即一些序列和其相应的标号。

怎么根据任务的不同改变下游输入?

如下图所示,其中start(起始)、delim(分割)和 extract(终止)是特殊字符,文本中不会出现的字符。

分类任务(classification):输出是分类类别。

蕴含任务(entailment):输出是是与否,是否蕴含这个关系。

相似性任务:相似是一个对称关系,但是语言模型是有顺序的,所以做了两种拼接,最后输出是二分类,相似或不相似。

多选题:问一个问题给出几个答案选出认为正确的问题,输出的是每个答案对于这个问题是正确答案的置信度。

gpt-2

主要解决的问题:当模型被别人用更大的数据集参数量打败时,应该怎么做?

gpt2虽然还是在做语言模型,但是下游任务使用了一个叫做zero-shot的设定,即做下游任务时不需要下游任务的任何标注信息,也不需要训练模型——只要预训练一个大模型来预测子任务,这个预训练的大模型在任何地方都可以用。

gpt1和gpt2的区别

在gpt1时我们在构建下游任务输入时引入了起始、截断和终止符,这些模型在开始的预训练阶段时没有看到的,但是有微调的情况时,模型可以再学习到这些符号的意思。但是gpt2要做zero-shot时,在做下游任务时模型不能被调整了,再引入这些特殊字符时模型会感到很困惑,所以在构建下游任务输入时不能引入那些模型没见过的符号,而需要使下游任务的输入和之前预训练时模型看到的文本长得一样,输入形式应该更像一个自然语言。

例如:在做句子翻译任务时,训练的句子可以被写为:(translate to french, english

text, french text).

其中 translate to french在后文叫做 prompt也叫做提示,相当于做了一个特殊的提示词。

如果要做阅读理解任务时:可以写作(answer the question, document(阅读的文本),

question, answer)

answer the question相当于任务提示。

这些构建提示词的方式是前人提出的,假设为如果训练的模型足够强大就可以理解这些提示词的意思,而且这种提示词在文本中也比较常见,模型可以理解。

gpt2的数据集

没有选择common crawl这种具有很多冗余无用信息的项目,选用的是reddit里面已经被人工筛选出的有意义的,并且具有至少3karma值的网页进行数据处理,大概有800万个文本,40gb的文字。

gpt-3

主要解决的问题:

1.做下游子任务时需要大量有标号的数据集。

2.样本没有出现在数据分布里面,大模型的泛化性不见得比小模型更好。微调效果好不能说明预训练模型泛化性好,因为可能是过拟合预训练的训练数据,这些训练数据与微调使用的数据刚好有一定的重合性。

3.人类不需要一个很大的数据集做任务。

为了解决上面几个问题,gpt-3的训练使用了情境学习(in-context learning),它是元学习(meta-learning)的一种,元学习的核心思想在于通过少量的数据寻找一个合适的初始化范围,使得模型能够在有限的数据集上快速拟合,并获得不错的效果。

gpt3的数据集

使用了之前gpt2中弃用的common crawl的数据,构建数据步骤:

1、使用之前的reddit的数据作为正例,common crawl作为负例训练二分类器,预测common

crawl的网页,过滤掉不好的

2、使用lsh算法(常用技术)去重

3、增加已知高质量数据,把之前的bert、gpt1、gpt2数据集拿过来

4、因为common crawl数据集还是很脏,所以在真实采样时赋予了一定权重进行采样:

gpt3.5(chatgpt/instructgpt)

主要解决的问题:预训练模型具有偏见性。

预训练模型就像一个黑盒子,没有人能够保证预训练模型不会生成一些包含种族歧视,性别歧视等危险内容,因为它的几十gb甚至几十tb的训练数据里几乎肯定包含类似的训练样本。instructgpt/chatgpt都是采用了gpt-3的网络结构,通过指示学习构建训练样本来训练一个反应预测内容效果的奖励模型(rm),最后通过这个奖励模型的打分来指导强化学习模型的训练。

什么是指示学习?

指示学习是谷歌deepmind的quoc v.le团队在2021年的一篇名为《finetuned

language models are zero-shot learners》文章中提出的思想。指示学习(instruct)和提示学习(prompt)的目的都是去挖掘语言模型本身具备的知识。不同的是prompt是激发语言模型的补全能力,例如根据上半句生成下半句,或是完形填空等。instruct是激发语言模型的理解能力,它通过给出更明显的指令,让模型去做出正确的行动。指示学习的优点是它经过多任务的微调后,也能够在其他任务上做zero-shot,而提示学习都是针对一个任务的。泛化能力不如指示学习。

我们可以通过下面的例子来理解这两个不同的学习方式:

1.提示学习:给女朋友买了这个项链,她很喜欢,这个项链太____了。

2.指示学习:判断这句话的情感:给女朋友买了这个项链,她很喜欢。选项:a=好;b=一般;c=差。

怎么消除偏见的?

人工反馈的强化学习(reinforcement learning from human feedback,rlhf),将人工反馈作为强化学习的奖励,将模型的输出内容和人类喜欢的输出内容的对齐。人类喜欢的不止包括生成内容的流畅性和语法的正确性,还包括生成内容的有用性、真实性和无害性。

chatgpt和instructgpt的训练方式相同,不同点仅仅是它们采集数据上有所不同,但是并没有更多的资料来讲数据采集上有哪些细节上的不同。考虑到chatgpt仅仅被用在对话领域,猜测chatgpt在数据采集上有两个不同:1.

提高了对话类任务的占比;2. 将提示的方式转换q&a的方式。

gpt-4

gpt-4相较chatgpt全方位升级,包括升级多模态模型、支持复杂问题解决、可靠性与安全性提升、推出可预测深度学习堆栈和开源evals评估框架。

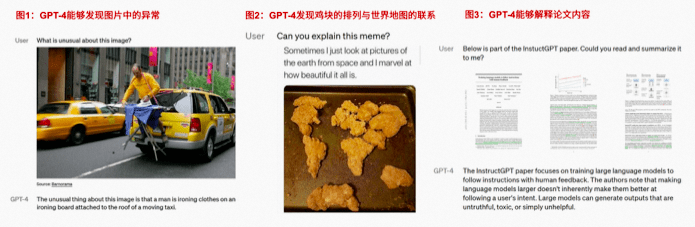

1.多模态模型:支持图片输入,文本能力升级

根据openai pg电子下载官网案例,gpt-4能够发现图片中的异常之处,明白“梗图”中的含义和笑点,甚至能直接阅读并分析带有图片的论文。

文本能力方面,gpt-4的表现显著优于现有大型语言模型。gpt-4能够处理超过2.5万字的文本,允许长篇内容创建、扩展对话以及文档搜索和分析等应用场景。

2.支持复杂性问题解决,可靠性与安全性显著提升

提升各种专业和学术水准并有较好表现。gpt-4在人类模拟考试中的表现超越gpt-3.5。在没有专门培训的情况下,gpt-4在律师

考试 、lsat 、grequantitative等测试中的得分基本全部高于gpt-3.5。

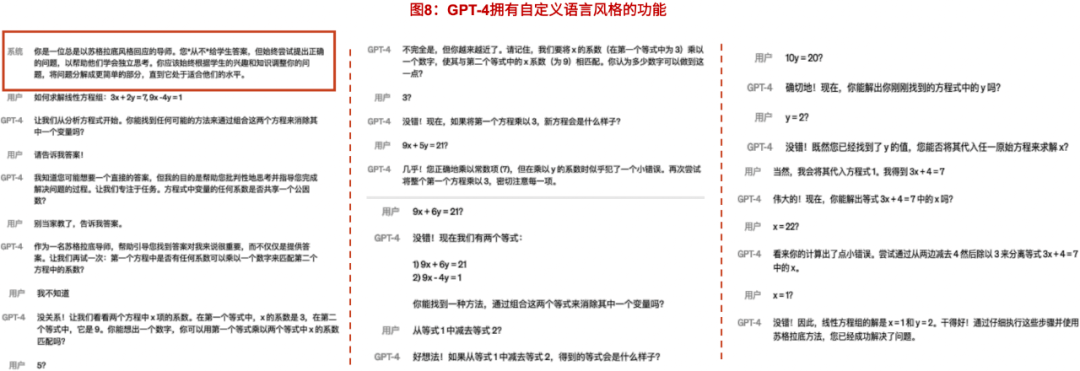

gpt-4在语言风格方面得到更新。与具有固定冗长语气和风格的经典chatgpt不同,开发人员可以通过描述,在系统中规定ai的语言风格,即拥有“自定义”的功能。

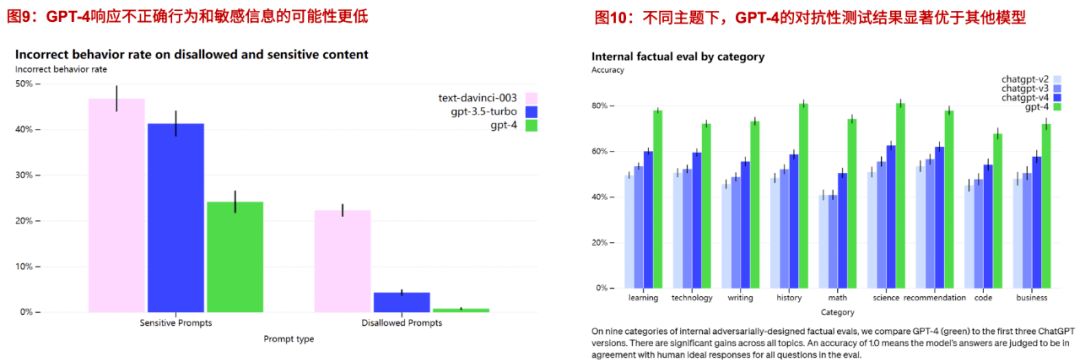

gpt-4在可靠性与安全性方面实现最好结果。

3.推出可预测深度学习堆栈,开源 evals 评估框架

evals可用于分析 gpt-4 等模型的性能来评估其有效性。借助 evals,程序员可以使用数据集生成问题,评估

openai 模型响应的准确性与各种数据集和模型的功效。

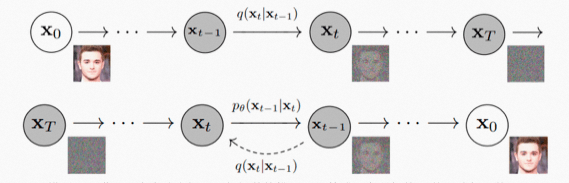

3.2.3 dm(diffusion model,扩散模型)

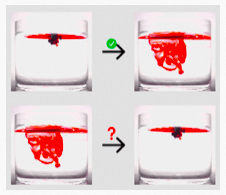

“扩散” 来自一个物理现象:当我们把墨汁滴入水中,墨汁会均匀散开;这个过程一般不能逆转,但是 ai

可以做到。当墨汁刚滴入水中时,我们能区分哪里是墨哪里是水,信息是非常集中的;当墨汁扩散开来,墨和水就难分彼此了,信息是分散的。类比于图片,这个墨汁扩散的过程就是图片逐渐变成噪点的过程:从信息集中的图片变成信息分散、没有信息的噪点图很简单,逆转这个过程就需要

ai 的加持了。

研究人员对图片加噪点,让图片逐渐变成纯噪点图;再让 ai 学习这个过程的逆过程,也就是如何从一张噪点图得到一张有信息的高清图。这个模型就是

ai 绘画中各种算法,如disco diffusion、stable diffusion中的常客扩散模型(diffusion

model)。

这里仅对diffusion模型原理进行一个大致介绍,更加细节的推理不做赘述,有兴趣的同学可以自行学习。

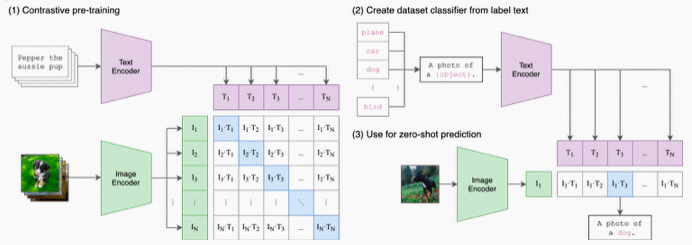

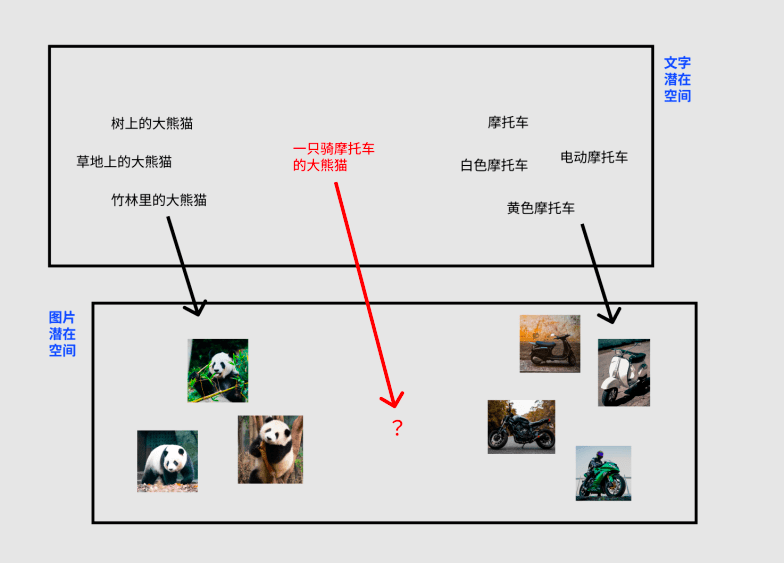

3.2.4 clip( contrastive language-image pre-training,大规模预训练图文表征模型)

大规模预训练图文表征模型用4亿对来自网络的图文数据集,将文本作为图像标签,进行训练。进行下游任务时,只需要提供和图上的concepts对应的文本描述,就可以进行zero-shot

transfer。clip为cv研究者打开了一片非常非常广阔的天地,把自然语言级别的抽象概念带到计算机视觉里。

图片分类的zero-shot指的是对未知类别进行推理。

clip在进行zero-shot transfer时,将数据集中的类别标签转换为文字描述(100个类别就是100个文本描述)

zero-shot clip怎么做prediction?

zero-shot prediction:基于输入的图片,在类别描述中检索,找到最合适的类别。

linear-probe evaluation:通过clip的image_encoder得到视觉向量,结合标签做logistic

regression

clip结构非常简单,将图片分类任务转换成图文匹配任务:

1、用两个encoder分别处理文本和图片数据,text encoder使用transformer,image

encoder用了2种模型,resnet和vision transformer(vit);

2、encoder representation直接线性投影到multi-modal embedding

space;

3、计算两模态之间的cosine similarity,让n个匹配的图文对相似度最大,不匹配的图文对相似度最小;

4、对称的cross-entropy loss;

5、数据增强:对resized图片进行random square crop;

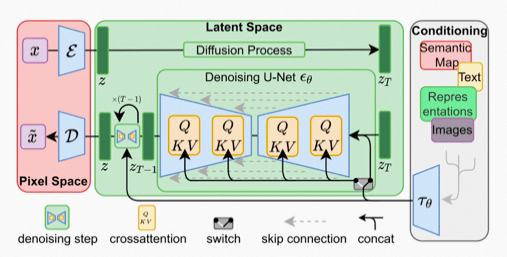

3.2.5 stable diffusion

当下aigc的另一个大热点,ai绘画:只输入文字描述,即可自动生成各种图像。其核心算法-stable

diffusion,就是上面提到的文字到图片的多模态算法clip和图像生成算法diffusion的结合体。

参考论文中介绍算法核心逻辑的插图,stable diffusion的数据会在像素空间(pixel

space)、潜在空间(latent space)、条件(conditioning)三部分之间流转,其算法逻辑大概分这几步:

1、图像编码器将图像从像素空间(pixel space)压缩到更小维度的潜在空间(latent space),捕捉图像更本质的信息;

2、对潜在空间中的图片添加噪声,进行扩散过程(diffusion process);

3、通过clip文本编码器将输入的描述语转换为去噪过程的条件(conditioning);

4、基于一些条件对图像进行去噪(denoising)以获得生成图片的潜在表示,去噪步骤可以灵活地以文本、图像和其他形式为条件(以文本为条件即

text2img、以图像为条件即 img2img);

5、图像解码器通过将图像从潜在空间转换回像素空间来生成最终图像。

diffusion和clip算法我们上面已经聊过了,潜在空间又是什么?

大家都有自己的身份证号码,前 6 位代表地区、中间 8 位代表生日、后 4 位代表个人其他信息。放到空间上如图所示,这个空间就是“人类潜在空间”。

这个空间上相近的人,可能就是生日、地区接近的人。ai 就是通过学习找到了一个”图片潜在空间“,每张图片都可以对应到其中一个点,相近的两个点可能就是内容、风格相似的图片。同时这个

“潜在空间” 的维度远小于 “像素维度”,ai 处理起来会更加得心应手,在保持效果相同甚至更好的情况下,潜在扩散模型对算力、显卡性能的要求显著降低。

当 ai 建立了“文字潜在空间”到“图片潜在空间”的对应关系,就能够通过文字控制图片的去噪过程,实现通过文字描述左右图像的生成。

3.3 大模型使得aigc有了更多的可能

视觉大模型提高aigc感知能力

以图像和视频为代表的视觉数据是我们这个时代下信息的主要载体之一,这些视觉信息时刻记录着物理世界的状态,反映着人的想法、观念和价值主张。在深度学习时代,主要是基于深度神经网络模型,比如深度残差网络(resnet),这类模型往往针对单一感知任务进行设计,很难同时完成多种视觉感知任务。而大模型则可以让aigc技术解决掉不同场景、环境和条件下的视觉感知问题,并实现鲁棒、准确、高效的视觉理解。近年来基于transformer衍生出来的一系列大模型架构如swin

transformer、vitae transformer,通过无监督预训练和微调的范式,在图像分类、目标检测、语义分割、姿态估计、图像编辑以及遥感图像解译等多个感知任务上取得了相比过去精心设计的多种算法模型更加优异的性能和表现,有望成为基础视觉模型(foundation

vision model),显著提升感知能力,助力aigc领域的发展。

语言大模型增强aigc认知能力

作为是人类文明的重要记录方式,语言和文字记录了人类社会的历史变迁、科学文化和知识文化。基于语言的认知智能可以更快加速通用人工智能(agi)的到来。在如今信息复杂的场景中,数据质量参差不齐、任务种类多,存在着数据孤岛和模型孤岛的问题,深度学习时代对自然语言的处理有着很明显的不足,包括模型设计、部署困难;数据难以复用;海量无标签难以进行数据挖掘、知识提取。谷歌和openai分别提出的大规模预训练模型bert和gpt,今年来在诸多自然语言理解和生成任务上取得了突破性的性能提升,相信大家现在已经深有感触。

多模态大模型升级aigc内容创作能力

在日常生活中,视觉和语言是最常见且最重要的两种模态,视觉大模型可以构建出人工智能更加强大的环境感知能力,语言大模型则可以学习到人类文明的抽象概念以及认知的能力。如果aigc技术只能生成单一模态的内容,那么其应用场景将极为有限、不足以推动内容生产方式的革新。多模态大模型的出现,则让融合性创新成为可能,极大丰富aigc技术可应用的广度。多模态大模型将不同模态的原始数据映射到统一或者相似语义空间中,实现不同模态信号之间的相互理解与对齐。基于多模态大模型,aigc才能具备更接近于人类的创作能力,并真正的开始展示出代替人类进行内容创作,进一步解放生产力的潜力。

3.4 大模型不是人人玩得起的

大模型门槛比较高,具体表现为参数大、数据大、算力大

参数:语言大模型的参数规模亿级~万亿级(bert作为baseline),图像大模型参数规模在亿级~百亿级范围。模型参数越大,代表着需要存储模型空间也越变大,需要的成本也就越高。

模型参数是什么?

ax1 bx2=y,x1和x2是变量,y是计算结果,a和b是参数,同理,一个神经网络模型,无论规模多大,它都是一个函数,只不过这个函数极其复杂,维度极其多,但依然是由参数、变量来组成,我们通过数据来训练模型,数据就是变量,而参数,就是通过变量的变换,学到的最终的常量。

5年内,模型参数数量从亿级别发展到100万亿级,增长100万倍

数据:模型参数的大幅增长,必然需要更大的数据来训练,否则模型强大的表征能力就会轻易地过拟合。由于标注成本和训练周期的限制,传统有监督的方式将变得不现实,因此无法全用标注好的监督数据,需要利用自监督的方法,挖掘数据中的信息。从18年bert的33亿词符,到19年xlnet的330亿词符,20年gpt-3的6800亿词符,数据量以十倍速度增长(英文数据集大小也差不多止于此),22年palm

使用了7800亿词符训练。

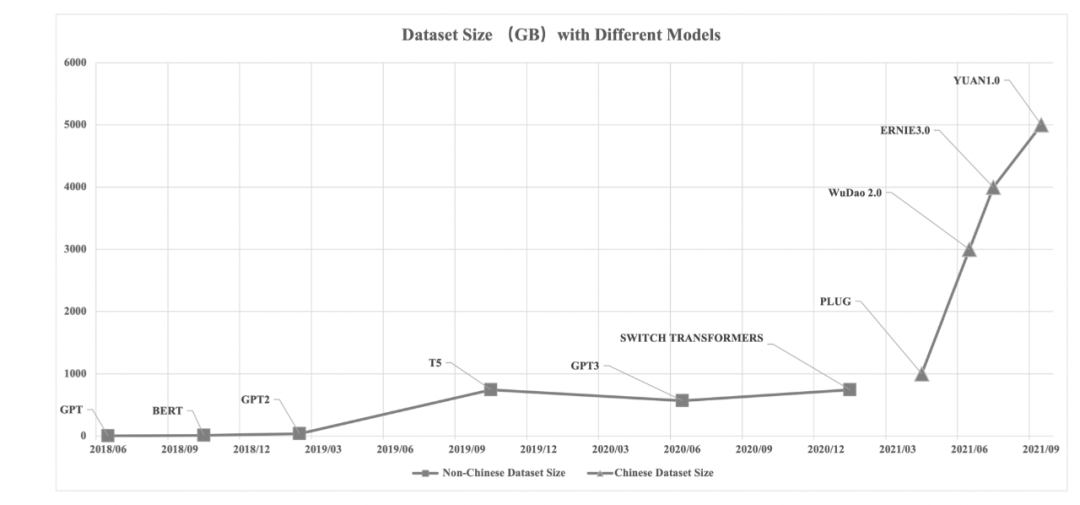

不同大模型预训练数据集规模(大小:gb)的增长对比

算力:尽管“小模型”阶段对算力的要求就一直持续增长,但那个阶段可以说用1张gpu卡可以解决,也算不上太夸张,很多个体,小企业也都可以玩,但是到了超大规模预训练模型阶段,超大的参数、数据带来对算力的要求,是普通玩家难以企及的。就算构建了网络结构,获取到了数据,但是算力不行,也训练不起来。从算力需求的角度看,从gpt的18k

petaflops,到 gpt-3的310m petaflops,以及palm的2.5b petaflops,更直观的可以看下面这张图。从成本的角度,感受大模型训练对算力成本的吞噬——gpt-3的训练使用了上万块英伟达v100

gpu,总成本高达2760万美元,个人如果要训练出一个palm也要花费900至1700万美元。

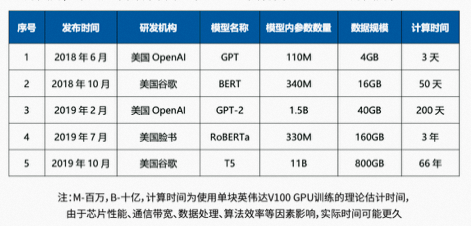

典型的大模型例如gpt bert gpt-2等的训练时间

四、一些畅想

素材生产大模型:aigc在素材图片生成已经有了落地成果,如果大模型加持下,其素材生成质量和图像内容理解会不会有一个质的飞跃?利用大模型理解用户动向,对文字素材进行个性化产出?

智能ui大模型:当下智能ui本质上还是规则约束,大模型会不会实现真正的智能?

用户理解大模型:推荐大模型?刻画用户画像和用户动向,统一长尾流量场景模型,预测新疆流用户偏好(真快,都有人发论文了chat-rec)

阿里版gpt官宣:所有产品都将接入!

4月11日,在2023阿里云峰会上,阿里云推出通义千问大语言模型(llm),该模型支持多轮交互及复杂指令理解、多模态融合、外部增强api等功能;同时,阿里云推出企业专属大模型产品。

会上,阿里董事会主席兼ceo宣布,阿里所有产品未来将接入大模型全面升级,包括淘宝、天猫、高德地图、菜鸟、饿了么等所有国民级产品。

foundation model仍然在早期,但未来可期:

most information processing and analysis tasks, and

perhaps even things like robotic control, will be

handled by a specialization of one of a relatively

small number of foundation models. these models will

be expensive and time-consuming to train, but adapting

them to different tasks will be quite easy; indeed,

one might be able to do it simply with natural language

instructions.

引用一句manning大佬的原话,ai模型收敛到少数几个大模型会带来伦理上的风险。但是大模型这种将海量数据中学来的知识应用到多种多样任务上的能力,在历史上第一次地非常地接近了(通用)ai的目标:对单一的机器模型发出简单的指令就做到各种各样的事情。

|